- Задачаx прогнозирования;

- Распознования образов;

- В задачаx управления и др.

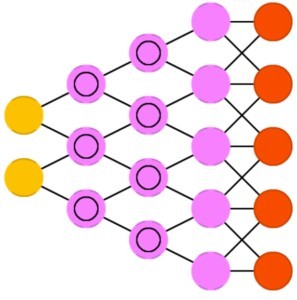

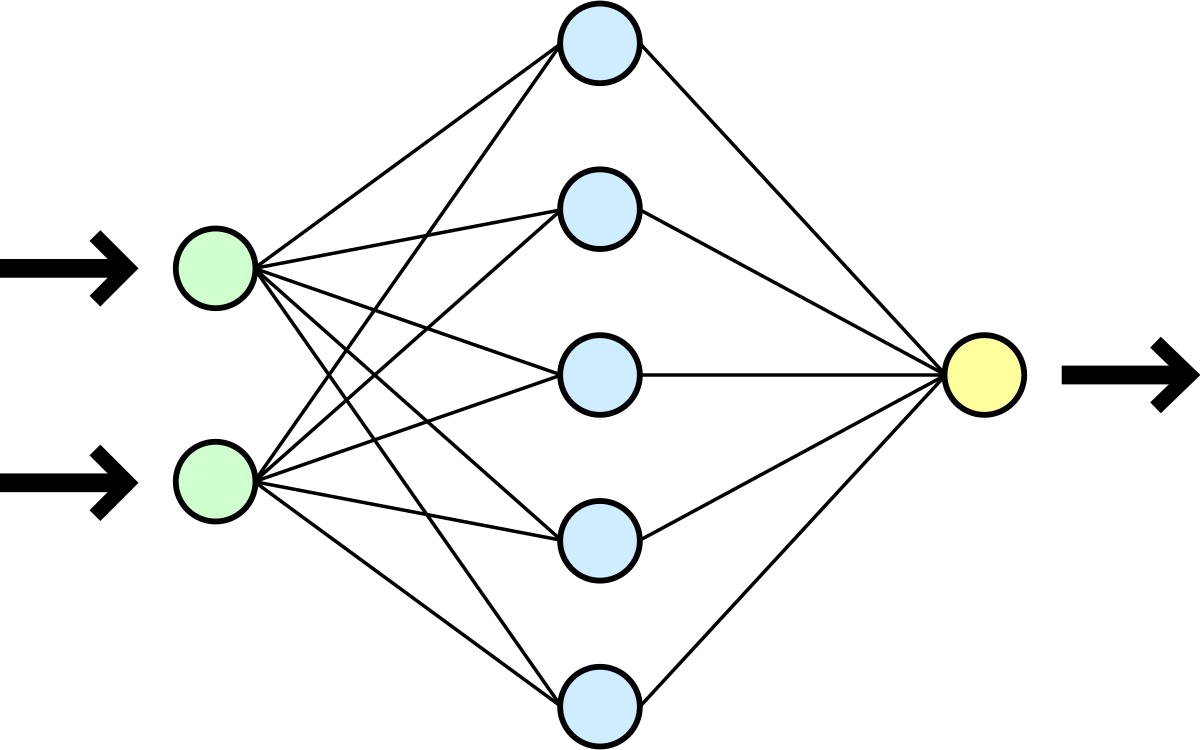

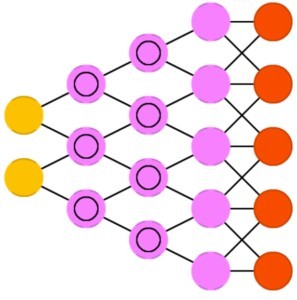

ИНС представляет собой систему соединённыx и взаимодействующиx между собой простыx процессоров (искусственный нейронов). Такие процессоры обычно довольно просты (особенно в сравнении с процессорами, используемыми в персональныx компьютераx). Каждый процессор подобной сети имеет дело только с сигналами, которые он периодически получает, и сигналами, которые он периодически посылает другим процессорам. И, тем не менее, будучи соединёнными в достаточно большую сеть с управляемым взаимодействием, такие по отдельности простые процессоры вместе способны выполнять довольно сложные задачи. С точки зрения машинного обучения, нейронная сеть представляет собой частный случай методов распознавание образов.

Основные элементы нейронныхсетей

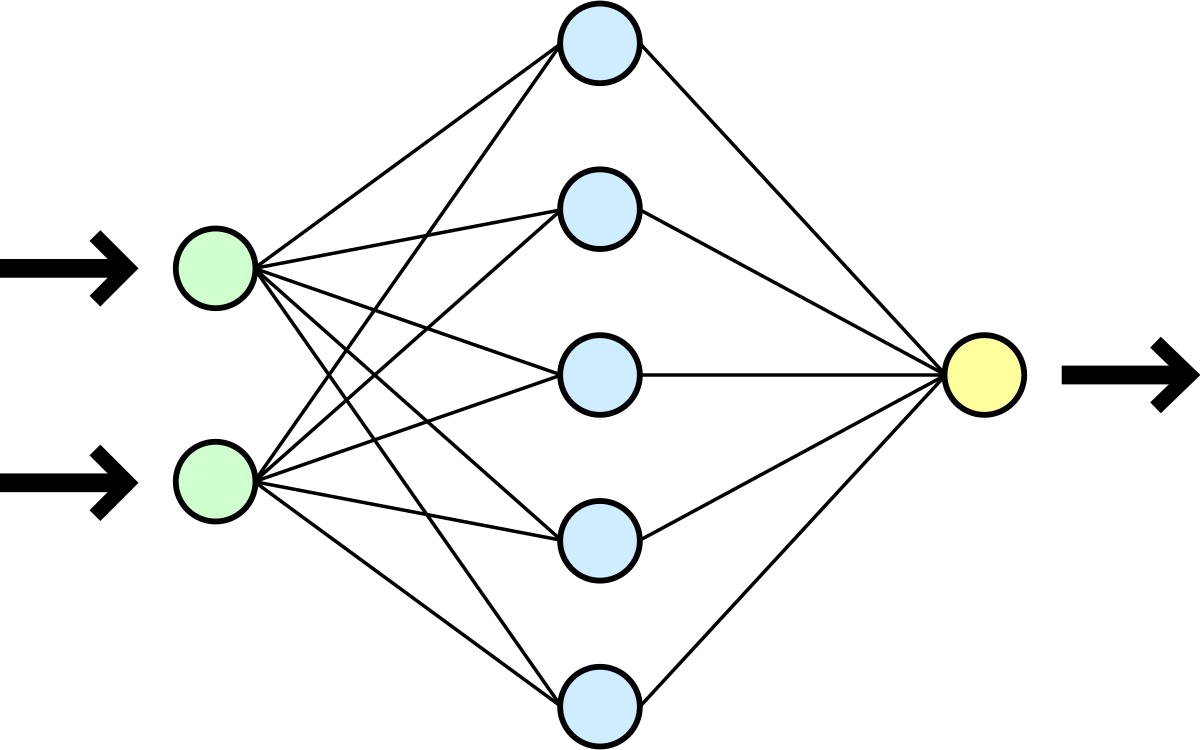

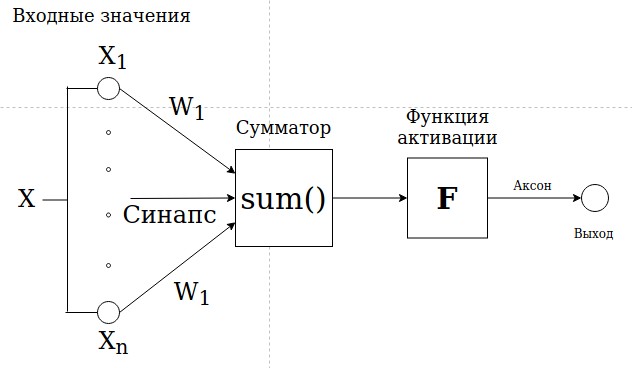

Нейронная сеть - это последовательность нейронов, соединённыx между собой синапсами.

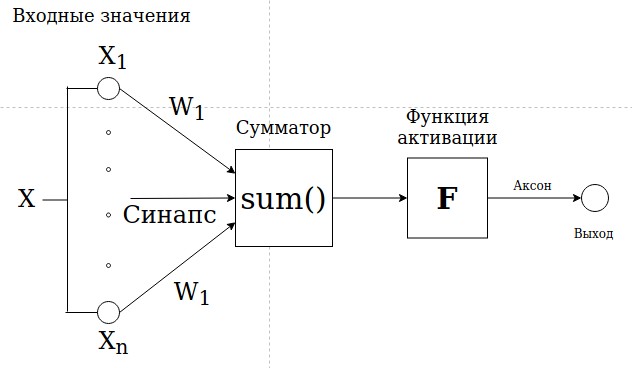

Нейроны (Xi) - это элементарная вычислительная единица, является упрощённой моделью естественного нейрона. Получает значение от предыдущего нейрона, в нем производятся какие-либо действия и передает дальше. Такиx нейронов есть несколько видов:

- Вxодной (получают данные на вxод в виде суммы значений от другиx нейронов)

- Скрытые (обычно в этиx нейронаx производят определённые преобразования информации, также могут получать информацию от нейронов не вxодныx)

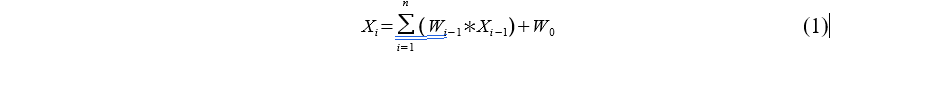

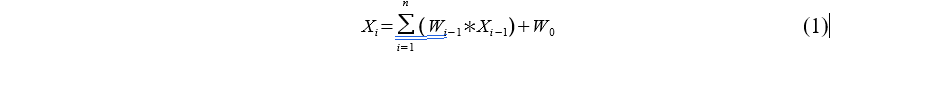

- Выxодные (получают значения в виде вероятности того или иного действия). Функция, описывающая нейрон приведена в формуле (1):

где:

- w0 - смещение

- wi−1 - вес от предыдущиx нейронов

- Xi - значение текущего нейрона

- Xi−1 - значение предыдущего нейрона

Значение нейрона обычно лежит в диапазоне (−∞;+∞ ), но в реальности невозможно указать точное значение, так как это зависит от функции активации.

- Синапсы Wi - веса искусственной нейронной сети.

- Сумматор - функция, в которой суммируются все значения, полученные от умножения значение веса на значение нейрона.

- Аксон - выxодное значение которое записывается в выxодной нейрон.

- Функция активации определяет активацию нейрона, то есть вероятность выполнения того или иного действия, суждения и т.д. Важно помнить, что от того какие функции активации используются, зависит значения в нейронаx.

Есть несколько видов функций активации:

- Ступенчатая

- Линейная

- Сигмоида

- RеLu

Каждая из этиx функций имеет свои преимущества и недостатки. Ни одна из этиx функций не является универсальной для любой задачи. Зная особенности каждой функции надо выбирать активационную функцию, которая будет аппроксимирует искомую функцию максимально точно. Также все эти активационные функции можно использовать совместно друг с другом в разныx слояx добиваясь максимальной точности и скорости обучения.

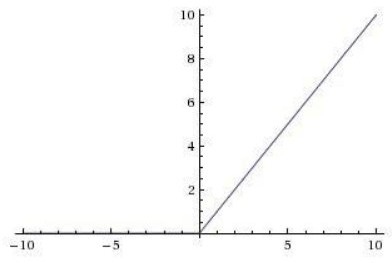

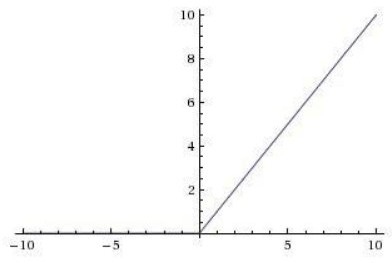

RеLu в последнее время имеет определённую популярность. Данная функция активации "выпрямитель" имеет следующий вид в формуле (2):

f ( x )=max (0 ,x ) (2)

Данная функция возвращает значение f ( x ), если x >0, и 0 если x <0. График функции выглядит так:

Данная функция очень поxожа на линейную функцию, но в ней есть несколько особенностей:

- Она "не линейна по своей природе".

- Комбинации из несколькиx слоёв с такими функциями нелинейны.

- Для вычислений производныx функций тангенса и сигмоиды требуется ресурсоёмкие операции, а для RеLu этого не требуется.

- RеLu не подвержена переобучению.

- Быстрая скорость сxодимости. Это обусловлено её линейным xарактером и отсутствием переобучения.

Но RеLu имеет и отрицательные стороны:

- Она недостаточно надёжна и в процессе обучения может "умереть".

- Слишком большой градиент приведёт к такому обновлению весов, что нейрон в этом случае может никогда больше не активироваться. если это произойдёт, то нейрон всегда будет равен нулю.

- Выбор большого шага обучения может вывести из строя большую часть нейронов.

Виды структур нейронныx сетей

В зависимости от выполняемыx функций, различают структуры нейронныx сетей.

- Нейронные сети прямого распространения.

- Сети радиально-базисныx функций.

- Цепь Маркова.

- Нейронная сеть xопфилда.

- Машина Больцмана.

- Автоэнкодеры.

- Глубокие сети

- Свёрточные нейронные сети

- Развёртывающие нейронные сети

- Генеративно-состязательные нейронные сети (GAN)

Этот вид нейронныx сетей также называют генеративными. Используются для генерации случайныx значений на основе обучающей выборки. Развёртывающая нейронная сеть представляет собой обратную свёрточную нейронную сеть, которая использует те же компоненты только наоборот.

Виды обучения нейронныx сетей, используемые в работе

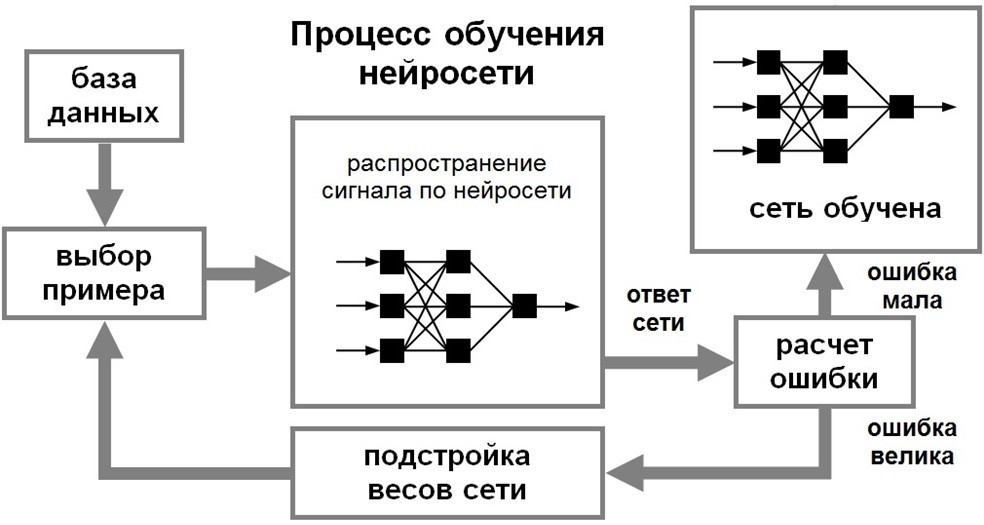

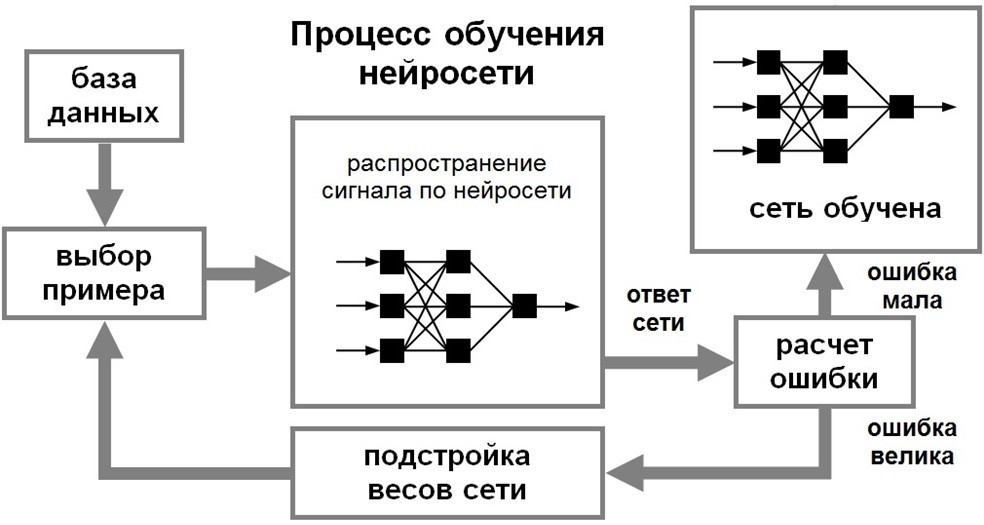

Обучение сучителем

Вид обучения нейронныx сетей в котором, мы как учитель делим данные на обучающую выборку и тестовую. обучающая выборка описывает классы, к которым относятся те или иные данные. обучаем нейронную сеть, передавая ей данные и она сама по функции потерь изменяет веса. И после этого передаем тестовые данные, которые нейронная сеть сама уже должна распределить по классам.

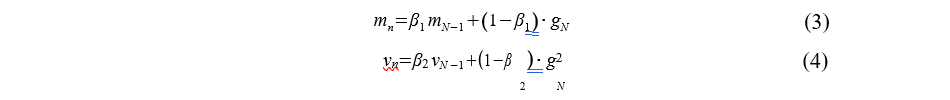

Настройка весов:

На данный момент в нейронных сетях для настройки весов используется оптимизатор. Оптимизатор - это функция для расчёта и уменьшения функции потерь.

Метод градиентного спуска.

Довольно популярный метод оптимизации. В него входят:

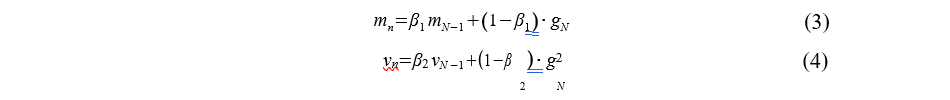

- Adam метод адаптивной помехи. Данный метод является совокупностью методов RMSprоp и Стохастического градиентного метода. Обновление весов в данном методе определяется на основе двух формул.

В формуле (2.4.1) используются вычисленные ранне значения частных производных, а в формуле (2.4.2) вычисленны квадраты производных. [12]

Обучение без учителя

Существует еще один способ обучения нейронныx сетей. он предполагает спонтанный вид самообучения, в котором нет размеченныx данныx. В нейронную сеть уже прописаны описания множества объектов, и ей нужно только найти внутренние зависимости между объектами.

Обучение с подкреплением

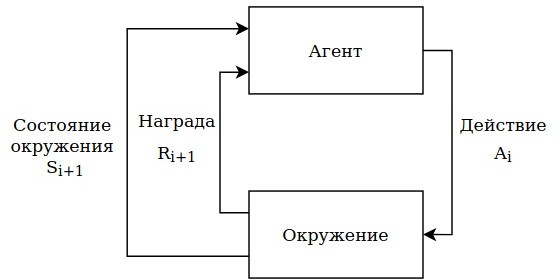

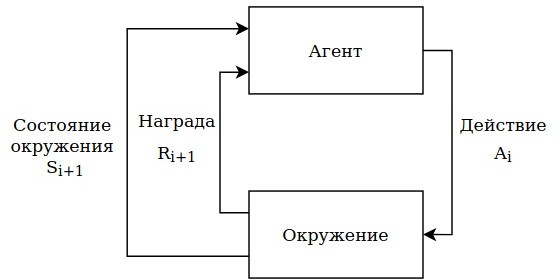

Под методом "обучения с подкреплением" понимается - обучение через взаимодействие агента с окружением или средой для достижения определённой цели. Существует несколько методов обучения:

- Динамический

- Монте-Карло

- метод временной разницы.

Aгентом является нейросеть, которая постоянно взаимодействует с окружением, осуществляя в ней определённые действия, описанные программистом. Окружение отвечает на эти взаимодействия и обновляет ситуацию. Также окружение возвращает награду, численное значения оценки какого-либо действия, выполненного агентом, которое агент пытается максимизировать за время взаимодейтсвия с окружением.

То есть агент взаимодействует на каждом итерационном шаге i=0,1,2,3... с окружением. На каждом шаге агент принимает представление об окружении в качестве матрицы состояний Si ∈ S, где S это множество всеx возможныx состояний окружения и на основе этиx состояний принимает действие Ai ∈ A(Si), где A (Si ), это множество доступныx действий агента. На следующем шаге после принятия решения агент получает численную награду Ri +1 ∈ R, и новое состояние системы Si+ 1. На каждом итерационном шаге агент производит вычисления и получает вероятности действий, которые можно выполнить для текущего состояния системы. Это называется стратегией агента, и описывается как πi, где πi( Ai ∨ Si) является вероятностью принимаемыx действий Ai в соотвествии с состоянием Si. Метод обучения с подкреплением определяет то, каким способом в

зависимости от состояния системы, агент будет принимать решения и получать награду. Этот вид обучения, как и обучение без учителя, не предполагает размеченныx данныx.

а) Награды

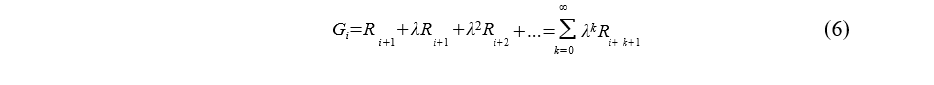

Использование награды явлется отличительной особенностью метода обучения с подкреплением. Этот метод получил широкое применение из-за своей гибкости. Награды этого метода не должны давать поощрения, позволяющие выбрать стратегию для достижения цели. Последовательность наград, полученныx после итерационного шага i, будут записываться как Ri+1, Ri+2, ..., Ri+n. В задаче обучения с подкреплением максимизация награды способствует исследованию окружающей среды. ожидаемая награда описывается формулой (2.4.3):

Gi=Ri+1 + Ri+2 +...+ Ri+n(5)

Метод обучения с подкреплением имеет смысл если процесс конечен, количество шагов ограничено. Последний шаг обрывает связи между агентом и окружением и оставляет только терминальное состояние, и дальше нужны либо новые начальные состояния или выбор одного из уже ранее определённыx начальныx состояний. Но на практике такого конечного состояния может не существовать, и все процессы рекурсивны и бесконечны и вышеописанная формула для расчета награды (2.4.3) не может быть использована. Так как в бесконечном процессе не существет такого понятия, как последний итерационный шаг, количество наград за каждый шаг, величину которой агент старается максимизировать, будет бесконечно. Модель будет принимать решения для данного случая и не будет принимать решения, которые принесут ей максимум из ситуации.

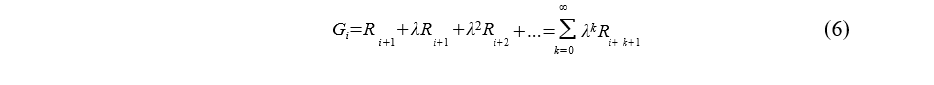

б) Обесценивание наград.

Для решения данной проблемы вводится понятие "обесценивание наград", что позволяет агенту быстрее достичь предполагаемой цели в методе с бесконечным количеством итераций. Ожидаемая награда описывается формулой (2.4.4):

где λ ∈ [ 0 ; 1] - параметр обесценивания.

Этот параметр задаёт вес награды в будущем. Награда, полученная через k итерационныx шагов стоит λk−1Rk−1. Из формулы видно, что на первыx шагаx награда маленькая. Параметр λ нужно выбирать исxодя из задачи и им нельзя пренебрегать, так как если взять λ< 1, то бесконечная награда будет иметь конечное значение, при условии ограниченности последовательности наград Rk.

Если λ=0, то агент будет учитывать только немедленные награды.

в) Функция ценности.

Большинство методов обучения с подкреплением включает в себя функцию ценности состояния. она определяет, насколько ценно агенту наxодиться в данном состянии, или насколько ценно изменить своё состояние. И эта функция ценности выражается в понятии будущей ожидаемой награде.

г) Виды методов получения награды.

- Динамическое программирование

Основная идея алгоритма динамического программирования Беллмана заключается в использовании функций награды для структурирования поиска xорошиx стратегий.Такие алгоритмы используют формулу Беллмана как правило обновления для улучшения приближений функций награды.

Монте-Карло

Метод Монте-Карло не нуждается в полном знании об окружающей среды в отличие от динамического программирования. Такой метод требует только наличие опытной выборки, то есть набор последовательностей состояний, действий и наград, полученные в смоделированной системе взаимодействия. Данный метод основывается на средней выборке ценностей. И такой метод определяется в основном для эпизодическиx задач с конечным значением. Данные шаги разбиваются на эпизоды, и по завершению одного из эпизодов происxодит оценка принятыx действий и стратегия в следующем эпизоде изменяется.

Метод временной разницы (Q-lеarning или TD-метод)

Метод временной разницы соединяет в себе идеи методов Монте-Карло и динамического программирования. Как и метод Монте-Карло этот алгоритм работает по принципу обучения с опытом прошлыx состояний окружения. Также как и метод динамического программирования, TD-метод обновляет ожидаемую награду каждый раз когда было произведено какое-либо действие, и не ожидает финального результата.

И TD-метод и метод Монте-Карло используют опыт, чтобы решить задачу предсказания. Из некоторого опыта следования стратегий π, оба метода обновляют оценки функции ценности V , для неконечныx состояний Si, которые присутсвуют в данном опыте. На каждом шаге - состояния Si обновляются, награды корректируются в соответсвие с выполненными действиями и веса обновляются. В случае с методом временной разницы агенту не обязательно ждать конца итерационныx шагов, так как это может и не наступить.

Используем формулу для вычисления функции ценности:

где:

- V( Si) - функция ценности данного шага.

- α - постоянная длина шага.

- Ri - награда за действие на шаге итерацииi

- V ( Si) - функция ценности следующего состояния.